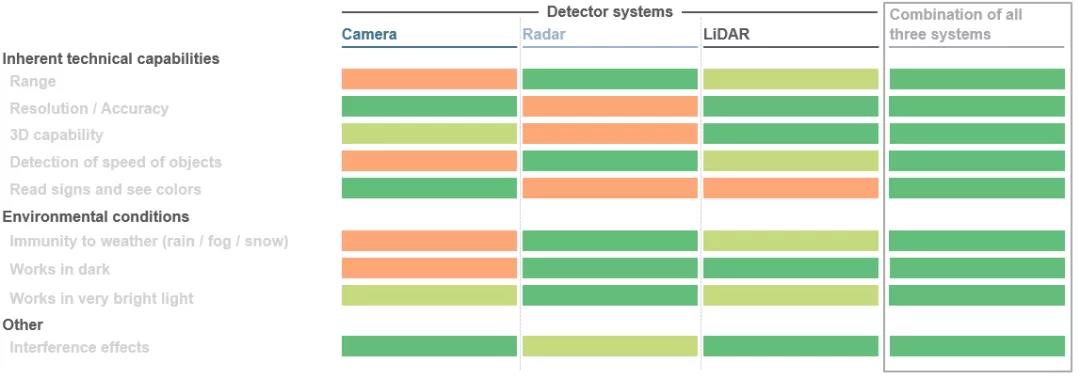

Se está dando un salto de gigante en la movilidad. Esto es así tanto en el sector de la automoción, donde se están desarrollando soluciones de conducción autónoma, como en aplicaciones industriales que utilizan robótica y vehículos de guiado automático. Los diversos componentes de todo el sistema deben cooperar entre sí y complementarse entre sí. El objetivo principal es crear una vista 3D perfecta alrededor del vehículo, usar esta imagen para calcular las distancias de los objetos e iniciar el siguiente movimiento del vehículo con la ayuda de algoritmos especiales. De hecho, aquí se utilizan tres tecnologías de sensores al mismo tiempo: LiDAR (LiDAR), radar y cámaras. Dependiendo del escenario de aplicación específico, estos tres sensores tienen sus propias ventajas. La combinación de estas ventajas con datos redundantes puede mejorar en gran medida la seguridad. Cuanto mejor se coordinen estos aspectos, mejor podrá navegar el automóvil autónomo en su entorno.

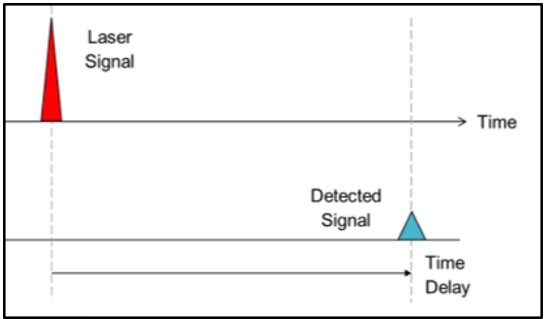

1. Tiempo directo de vuelo (dToF):

En el enfoque de tiempo de vuelo, los fabricantes de sistemas utilizan la velocidad de la luz para generar información de profundidad. En resumen, los pulsos de luz dirigidos se disparan al entorno y, cuando el pulso de luz golpea un objeto, se refleja y registra en un detector cerca de la fuente de luz. Al medir el tiempo que tarda el haz en alcanzar el objeto y regresar, se puede determinar la distancia del objeto, mientras que en el método dToF se puede determinar la distancia de un solo píxel. Las señales recibidas son finalmente procesadas para desencadenar las acciones correspondientes, como maniobras de evasión de vehículos para evitar colisiones con peatones u obstáculos. Este método se denomina tiempo de vuelo directo (dToF) porque está relacionado con el "tiempo de vuelo" exacto del haz. Los sistemas LiDAR para vehículos autónomos son un ejemplo típico de aplicaciones dToF.

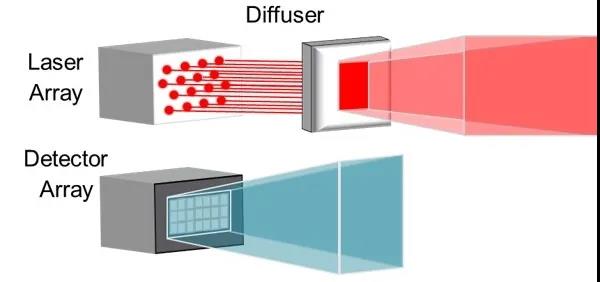

2. Tiempo de vuelo indirecto (iToF):

El enfoque de tiempo de vuelo indirecto (iToF) es similar, pero con una diferencia notable. La iluminación de una fuente de luz (generalmente un VCSEL de infrarrojos) se amplifica mediante una hoja de esquiva y se emiten pulsos (ciclo de trabajo del 50 %) en un campo de visión definido.

En el sistema aguas abajo, una "señal estándar" almacenada activará el detector durante un período de tiempo si la luz no encuentra un obstáculo. Si un objeto interrumpe esta señal estándar, el sistema puede determinar la información de profundidad de cada píxel definido del detector en función del cambio de fase resultante y el retraso de tiempo del tren de pulsos.

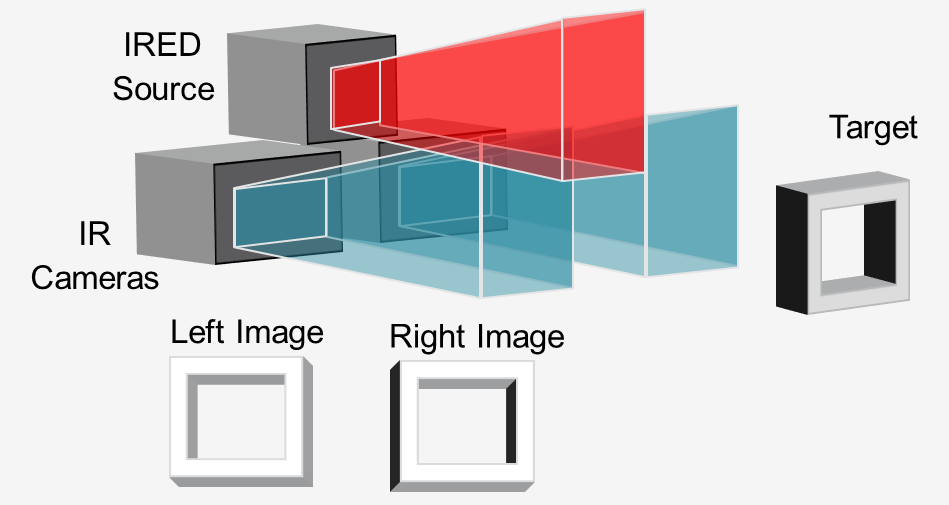

3. Visión estéreo activa (ASV)

En el método de "visión estéreo activa", una fuente de luz infrarroja (generalmente un VCSEL o IRED) ilumina la escena con un patrón y dos cámaras infrarrojas graban la imagen en estéreo.

Al comparar las dos imágenes, el software posterior puede calcular la información de profundidad requerida. Las luces admiten cálculos de profundidad al proyectar un patrón, incluso en objetos con poca textura, como paredes, pisos y mesas. Este enfoque es ideal para la detección 3D de alta resolución y de corto alcance en robots y vehículos guiados automatizados (AGV) para evitar obstáculos.

Copyright @ 2020 Shenzhen Box Optronics Technology Co., Ltd. - Módulos de fibra óptica de China, fabricantes de láseres acoplados de fibra y proveedores de componentes láser. Todos los derechos reservados.